Microsoft Ignite 2023現地参加ブログ|11/17「Inside Microsoft AI innovations with Mark Russinovich」キーノート要約

Igniteは昨日(2023.11.15 9AM~(米国時間))開催されました。

Microsoft Ignite 2023では、技術の未来についての壮大なビジョンを掲げています。

このイベントでは、AI、クラウドインフラストラクチャ、データ管理、などさまざまなアップデートや新サービスが発表されます。

今回は3日目のクロージングセッション「Inside Microsoft AI innovations with Mark Russinovich」キーノートのについて要約していきます。

本のセッションでは改めてAI技術の最前線を探る内容でした。

講演者は、AzureのチーフテクノロジーオフィサーであるMark RussinovichとSeth Juarezです。

持続可能なデータセンターから始まり、最先端のAIハードウェアとサーバー、そして最新のAIイノベーションに至るまで、幅広いトピックについて話しました。

目次

1. 持続可能なデータセンターの内部

データセンターPUEの進化:

Microsoftは、データセンターの効率を測定するPUE(Power Usage Effectiveness)を改善してきました。2007年に1.5-1.8だったPUEは、2023年には大幅に改善され、高温での運用や水冷式クーリングの導入など、様々な技術革新が行われています。

①データセンターのバックアップ電源:

Microsoftは、ディーゼル発電機から環境に優しい水素燃料電池への移行を進めています。これにより、データセンターのバックアップ電源がより持続可能になります。

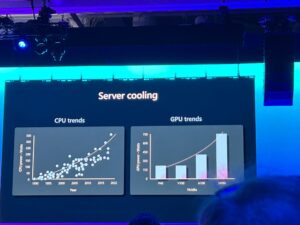

②サーバー冷却:

CPUとGPUの熱が増加する中で、Microsoftは伝統的な空冷から液体冷却へと移行しています。特に注目されているのは、マイクロ流体冷却技術です。これは、サーバーの熱負荷を効率的に処理する新しいアプローチです。

2.AIハードウェアとサーバーの内部

AIスーパーコンピュータ:

Microsoftは、OpenAIのために世界最大級のスーパーコンピュータを構築し、AIモデルのトレーニングに使用しています。

AIスーパーコンピュータに関して発表された重要なポイントは以下です。

①Azure Maia:

Azure Maiaは、Microsoftが開発したカスタムAIアクセラレーターです。これは、AIワークロードの効率を大幅に向上させることを目的としています。

②Maia software stack:

Maiaアクセラレーターは、専用のSDKとランタイムを備えており、これにより開発者は効率的にAIモデルを構築できます。デモでは、GitHub CopilotがMaiaを使用してAI駆動のコード生成を行う様子が示されました。

③Azure Boost-remote storage:

Azure Boostは、リモートストレージ操作を加速するためのデディケーテッドオフロードパートです。実際にデモが行われ、この技術により、650,000 IOPSと12.5GB/秒のスループットが達成されました。

Project Forge:

これは、AIワークロードに特化したリソースマネージャーで、リソースの使用効率を最大化します。

デバイスプロキシ:

AIのトレーニングと推論のための透過的なチェックポイントを提供し、ワークロードの管理と最適化を支援します。

3.AIの基礎モデルをチューニングするために

LLM(大規模言語モデル)

Microsoftは、LLMの概要とその使用方法について説明し、特にfine-tuning、prompt engineeringなどで利用されます。

①LLMの規模とデータセット:

LLMは通常、膨大な量のデータを読み込んで、事実上すべてを記憶しようとします。

例えば、LLaMA 1データセットは、インターネットから収集された多種多様なデータを含んでおり、議論グループやソーシャルメディア投稿など、望ましくないコンテンツも多く含まれています。

一方、Phiデータセットは合成の教科書データで、より高品質で純粋な科学と教科書のデータを提供し、有害なデータは含まれていません。

このような高品質のデータを使用することで、LLMは推論をより効率的に学習できます。

②ファインチューニングとRAG(Retrieval-Augmented Generation):

LLMは特定のタイプの言語を常に生成するようにファインチューニングすることができますが、大規模な医学情報などを扱う場合、RAGがより適していることが示されました。例えば、GitHub CopilotはGitHubの公開リポジトリ上のソースコードでファインチューニングされ、特定のタスクを行うカスタムモデルとして機能します。

ファインチューニングは、大規模データセットでトレーニングされたベースモデルを取り、特定の小規模ターゲットデータセットでトレーニングを再開することを含みます。

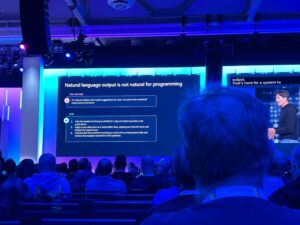

③出力形式と構造:

LLMは、例えば「シアトルで雨が降っている。行くべき場所を3つ教えて」といったプロンプトに対して自然言語出力を生成します。これはシステムにとって処理が難しい場合があります。OpenAIはGPT-4とGPT-3.5 Turboで「JSONモード」を導入し、モデルがこのモードで動作している場合にJSON出力を生成するようにファインチューニングされています。これにより、より整形されたJSON出力が得られますが、特定のスキーマに従うことは保証されていません

4.NVIDIAとのパートナーシップ

本イベントで発表されたAIサービスはMicrosoftがNVIDIAと協力されて構築されたデータセンター内のGPUを駆使して提供されています。

機密AIビジョンをもとに、データとモデルの両方を保護し、複数のパーティ間でデータを安全に共有することが可能になっているとのこと。

よって、自社のデータをもとに機械学習や分析をされるといった心配はありません。

このセッションは、AIと持続可能な技術の進化の現状を理解する上で非常に重要であり、今後のイノベーションへの期待を高める内容でした。

現地レポートブログ一覧へ

⇒https://cloud.nissho-ele.co.jp/blog/microsoft-ignite-2023/

この記事を書いた人

- 黒岩 彩

この投稿者の最新の記事

- 2024年1月4日ブログCitrix Cloudとは?~Citrix DaaSについても解説~

- 2023年11月26日ブログMicrosoft Ignite 2023現地参加ブログ|11/17「Inside Microsoft AI innovations with Mark Russinovich」キーノート要約

- 2023年11月26日ブログMicrosoft Ignite 2023現地参加ブログ|11/16「The Future of Security with AI」キーノート要約

- 2023年11月18日ブログMicrosoft Ignite 2023現地参加ブログ|11/16「Microsoft Cloud in the era of AI」キーノート要約(後半)