【Azureでデータ分析】

データ基盤導入のポイントと3ステップ

昨今、事業やサービスを取り巻く「データ」を資源の1つととらえて、分析するためのインフラであるデータ基盤の重要性が増しています。

昨今、事業やサービスを取り巻く「データ」を資源の1つととらえて、分析するためのインフラであるデータ基盤の重要性が増しています。

すでにデータ活用の取り組みとして、

・大規模なデータ収集

・データ可視化

・高精度な分析能力

・リアルタイムな処理能力

これらを実現するためのデータ基盤の構築を目指しているIT担当の方も少なくないことでしょう。

そこで本ブログでは「データ基盤」そのものを体系的に整理しながら、Microsoft Azureの各サービスを活用することで実用的なデータ基盤を導入し、データ活用していく際に知っておきたいポイントについて解説いたします。

本ブログ内容はこのような方にオススメです。

● Azureを使ったデータ基盤導入のステップを知りたい方

● データ基盤導入から運用まででおさえておくべきポイントを知りたい方

なお本ブログは以下の資料を参考に記載しています。詳細についてご興味ある方は、資料をダウンロードのうえご確認ください。

目次

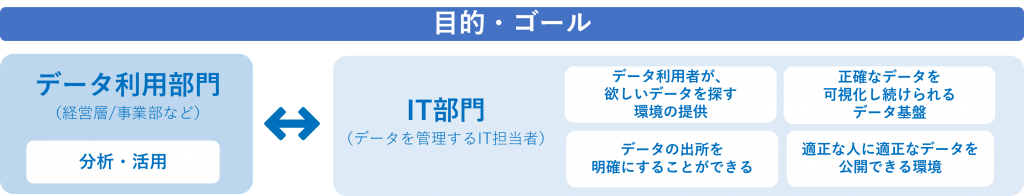

1. データ基盤導入にあたってIT部門の役割

社内でデータ活用を成功させるための体制や仕組みを考えた時、IT担当者が担う役割について整理してみます。IT担当者は、主にデータ活用を考える経営層や事業部/ユーザー部門に、データを収集、加工・可視化して提供する役割を担うことが考えられます。その際に、把握しておくべきこととして、下記の4つのポイントが挙げられます。

①データ分析により得られるメリットを把握する

②データ分析の「目的」を、経営層、事業部と共有・合意する

③分析に活用できるでデータを特定できる

④データの「可触性」「信頼性」「保守性」「機密性」について社内で先導する

特にデータは、貴重な資源であるだけに、IT担当者は利便性のみならず、セキュリティ面や統制が効いたデータ利用など、ガバナンスの観点を持つことも求められます。このように、データを確実に管理することから、安全かつ便利に活用してもらうための基盤を整えることが重要な役割といえます。

Microsoft Azureを活用することて、セキュリティとガバナンスをサービスで簡単に統制することが可能です。

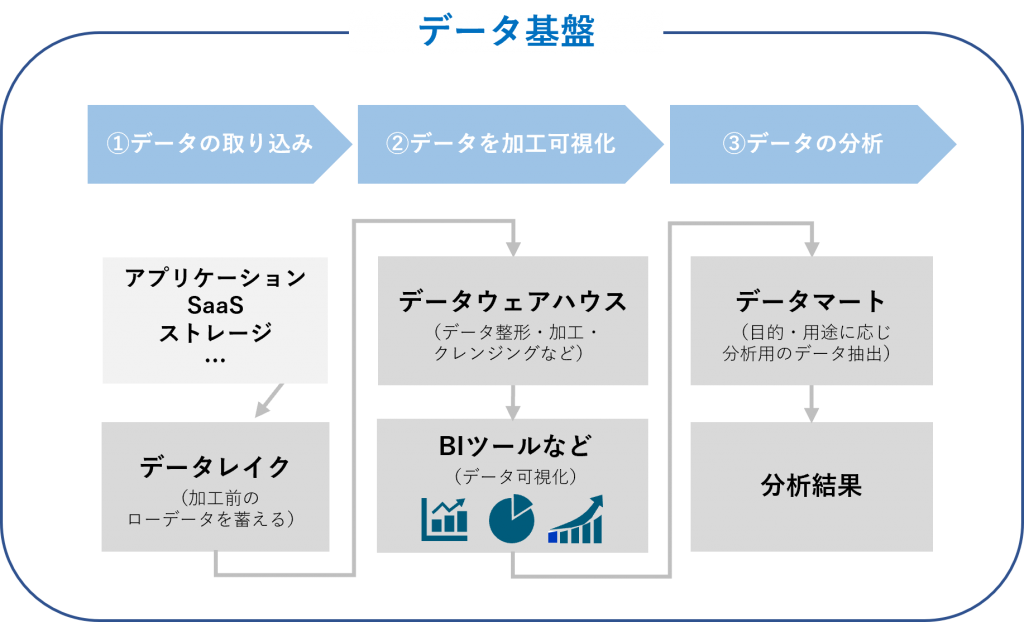

2. データ基盤に求められる3つの要素

データ基盤を構成する要素としては、データ分析のプロセスに対応する次の3つの要素が考えられます。

↑一般的なデータ基盤の要素

↑一般的なデータ基盤の要素

①データの取り込み

オンプレミス、クラウド上のアプリケーションやデータベース、ストレージなどに散在するデータを収集し保存します。

活用するAzureサービス

・Azure DataFactory

・Azure DataLake Storage

②データを加工可視化

ローデータを分析しやすいように整形、加工、クレンジングします。加工したデータはグラフ化するなど可視化されます。

活用するAzureサービス

・Azure Databricks

・Azure Synapse Analytics

・Azure DataLake Analytics

・Power BI

③ データ分析とガバナンス

目的に合った結果が出せるよう分析手法を定めて、分析ツールを活用するなどして分析結果を導き出します。

活用するAzure サービス

・Azure Machine Learning

・Azure AD

・Azure Sentinel

これらの要素の導入をまずは小さく、できる範囲のデータ分析からはじめて、ステップアップしていくことがオススメです。小さな成功を積み重ね、成功を繰り返しながらデータの量を増やしていくことで、高度な分析も可能になります。

3. Azureで導入するデータ基盤 3つのステップ

3つのステップを通じて、データ基盤を活用した分析の始め方とゴールについて紹介します。第一歩は地味かもしれませんが、実行してみると、意外に自社の数字を把握していなかったことに気づかされます。まずは、ステップ1から順に経験・実績を蓄積していき、ステップアップを目指しましょう。また、ステップごとにAzureを活用した構成例も紹介します。

ステップ①

スモールスタート(過去のデータで把握)

データ基盤を活用するためには、スモールスタートでも目的設定・データ収集・加工・分析を行い、手応えをつかみながら、少しずつ拡張していくことが成功のコツです。重要なことは、社内に蓄積した過去のデータから、この手順を実施すること。そして、分析前に設定した仮説を検証し、改善のプロセスを回すことです。必要なデータ、不足しているデータなどがないか検証することも重要です。これらの検証を実施することで分析に必要なデータを蓄積することが可能となります。

ここでは「過去のデータを用いて検証できること」をゴールに、以下の手順で上記でご紹介した3つの要素を試します。

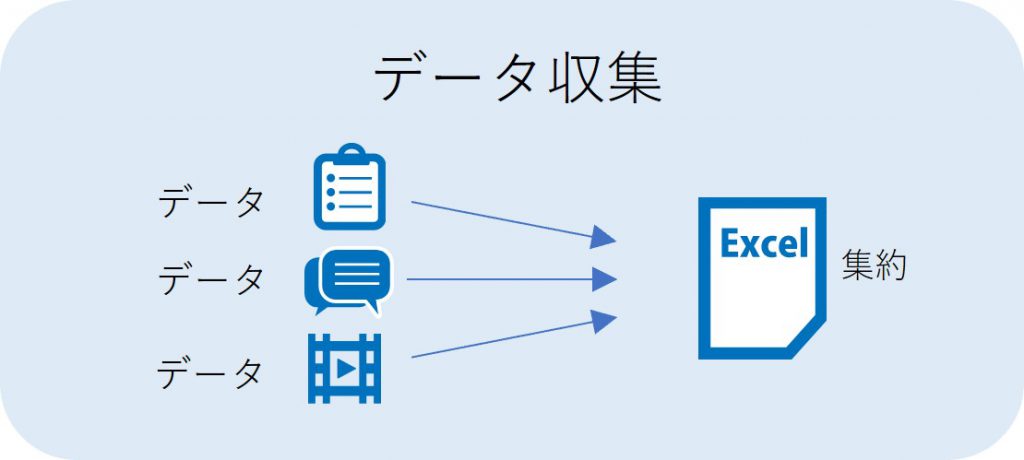

手順①:エクセルでデータを集める

まず、データ分析に用いる「素材」を集めます。データは全て自動的に集まるわけではないので、アプリケーション(SaaSなども含む)、データベース、ストレージ、Webサイトなどから収集し、まとめることになります。集めるデータは、ログを書き出す、CSV等で出力するなどするほか、データ収集ツールを用いて集めることなどが考えられます。

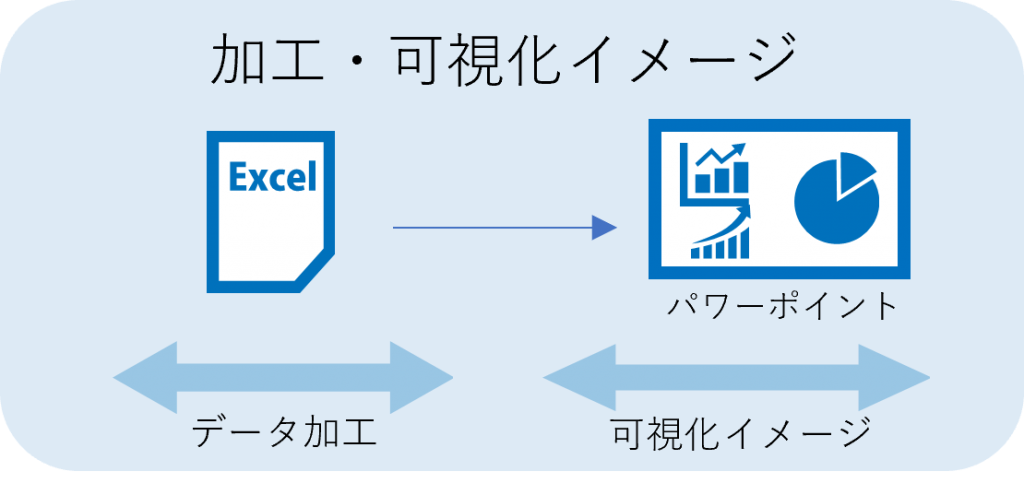

手順②:エクセルデータを手動で加工、可視化イメージをパワーポイントで作成

データを分析するためには、集めたデータをそのまま用いるのではなく、分析できる形に加工したり、形式を整えたりする必要があります。またその際には、不要なデータの排除、重複情報の統合などを行い分析に使用するデータのみを取り出すことも必要です。加工されたデータを読み解くためには、グラフや表組みを用いて、情報を可視化していきます。

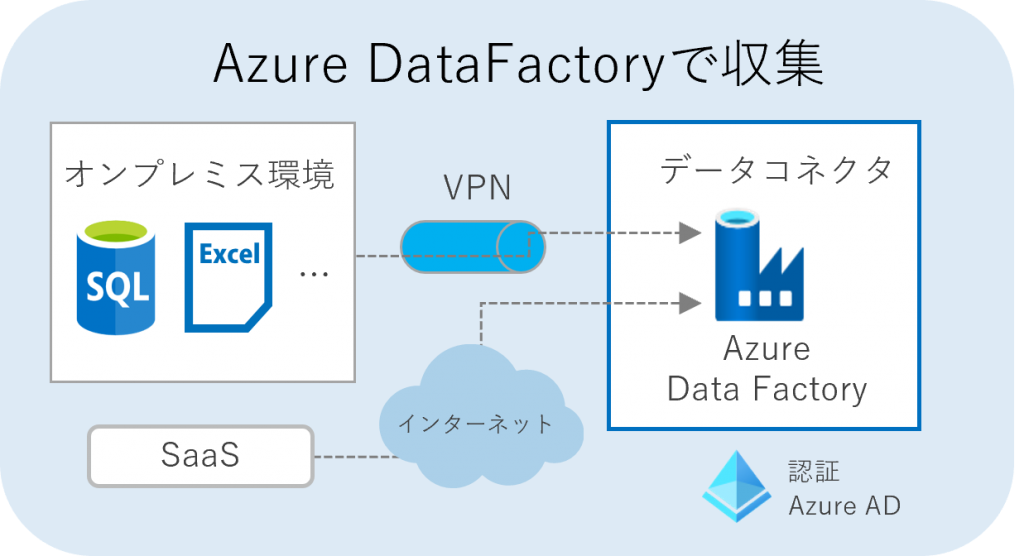

手順③:Azure Data Factoryによるデータ収集

手順①②で欲しいデータのカタチが定まったら、実際にAzureを活用してデータを収集してみましょう。ここではデータの抽出・読み込み・変換、データ統合などを行う機能を持つ、Azure Data Factoryを活用します。

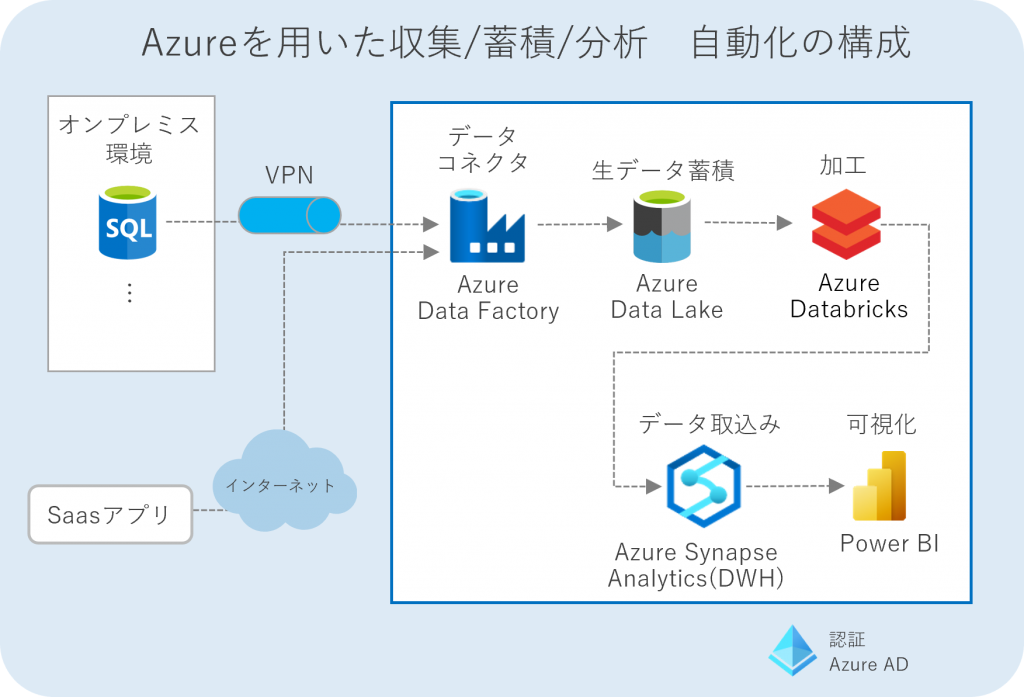

下記の構成では、社内のオンプレミス環境のデータベースやストレージ、SaaSなどクラウド上のアプリケーションなどに散在する企業データをAzure Data Factoryを活用して収集する仕組みを作っています。

なお、Azure上に収集したデータを蓄積する場合、Azure Data Lakeという大容量ストレージを活用することも可能です。

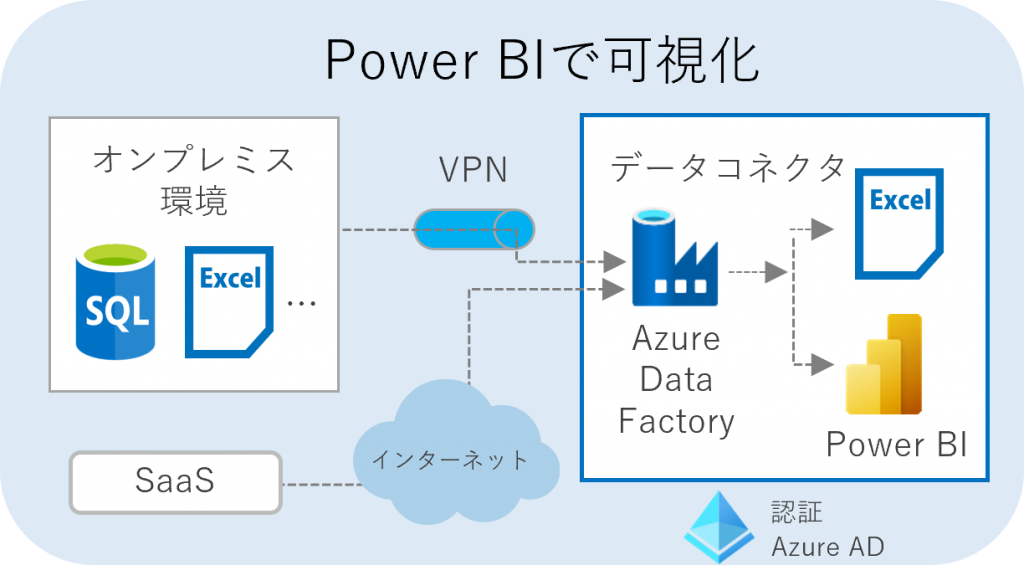

手順④:Power BIで可視化

Azure Data Factoryで、SalesforceやMarketoなどの営業・マーケティングツールの他、AWSやGoogle Cloudなどの外部クラウドプラットフォーム、MySQL ServerやOracle Databaseなどの多様なソースからデータを統合し、それらを分析可能な状態に変換します。データ量があまり多くない場合には、加工したデータをExcelにまとめるでもよいでしょう。しかし、Excelの操作は慣れ親しんだものかもしれませんが、データ加工には工数がかかる点が課題として挙げられます。データ量が大きい場合は、Microsoft Power BIでの可視化がオススメです。

手順⑤:利用部門と連携しながらデータ分析、検証

表やグラフなどの形に可視化されたデータを元に分析を行います。

データの分析手法は多種多様ですが、代表的な分析手法を知っておくことで分析が進めやすくなることでしょう。しかし、分析で重要なのは、当初に定めた目的に向かってデータを分析することです。可視化された情報や分析手法にとらわれず、「何を見たいのか、何を知りたいのか」を明確に持つことで、仮説に対する評価や次のアクションに効果的につなげることができます。

ステップ②

リアルタイムデータを分析する

下記のAzure サービスを活用することで、リアルタイムのデータを自動で収集、可視化することが可能です。ステップ①でスモールスタート/検証した内容で各部門と合意できた場合、これらを自動化します。

具体的には以下のAzureサービスを活用した構成にて実現できます。

Azure DataFactory

多様なソースからデータを統合し、それを分析可能な状態に変換するなどの作業を自動化

>>Azure DataFactoryとは

Azure Data Lake

Azure Date Factoryとの連携で、データの入出力・ジョブの実行などを自動化

Azure Databricks

構造データ/非構造ともに、データ集計・加工などを行い、データウェアハウスへ引き渡せる。バッチ分析も可能なので、大量データも加工可能

Azure Synapse Analytics

最新の「Azure SQL Data Warehouse」を使用しているため、ペタバイト規模でリレーショナルデータと非リレーショナルデータの両方をクエリすることが可能。構造化データ、ファイル形式、クエリ形式などの変換を行いPower BIに連携

Power BI

「各種データの抽出、変換、統合などの処理の実行と作成」「視覚化されたレポートの作成」「作成したレポートを組織内で共有」「作成したレポートを定期的に更新する」ことができ、これら機能をノンプログラミングで実行可能

>> Power BIとは

また、リアルタイムデータを使った分析を実施する場合、データの追加、データにノイズが入る場合など、改善のためのメンテナンスがIT部門には求められます。

必要なメンテナンス例

- データ分析を行う頻度が変更になる場合、データ同期スケジュールを変更

- データの追加がある場合、そのデータに合わせてソースの仕様 変更、データ属性に伴い、連携するツールの設定を変

- データ収集元の状態が変わる場合は、ファイル名/カラム/置き場所/アクセス権など、SaaSであれば API仕様などを変更

ステップ③

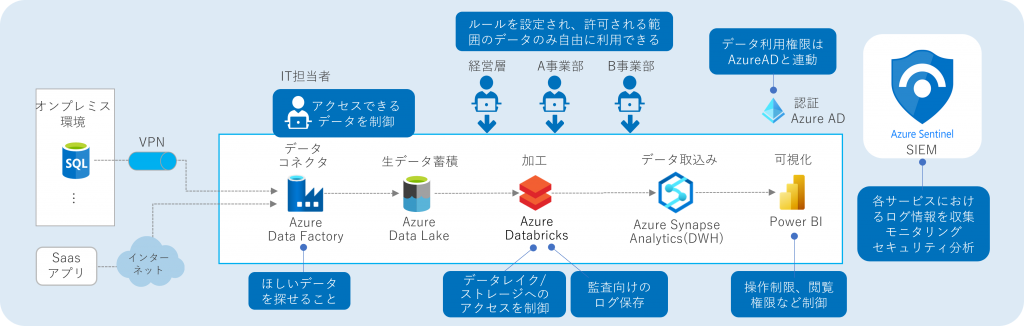

ガバナンスを効かせた運用の実現

自社内でのデータ利活用を進めるためのデータの管理方法、データに関するセキュリティ対策、データの品質基準、責任の所在など様々なルールを定めと統制を行うのが「データガバナンス」です。データ品質や安全性、利便性、正確性などを保つためにも必要なしくみです。IT担当の方は、データガバナンスが企業にもたらす効果を把握する必要があります。例えば、以下の効果があります。

・データを利活用する企業活動を統制できる

データ利活用を全社規模で行っていきたい場合に、社内の部署ごとの見解などが異なる場合でも、データガバナンスを徹底することで、統一的な見解でデータのか使い方を管理・統制できます。

・データの品質を担保や正確性などを担保することができる

データの収集・保管・分析などの体制に一貫性をもたせることで、品質を一定に保つことができます。

それでは、使いたい時、使いたいデータを分析に使える環境と、不正なアクセスからデータを安全に管理するためにどうすればよいのか、以下の図ではAzureサービスを活用することで強化できる例を紹介しています。

Azureサービスによるガバナンス強化例

Azure AD

ワークフロー機能によりアカウント管理を自動化し、安全な環境を維持することができます。ポリシーを設定することで、アカウントのプロビジョニングの自動化、権限状況のモニタリングなどを実現

>>Azure ADとは

Azure Sentinel

Azureが提供している セキュリティ情報イベント管理 (SIEM) および セキュリティ オーケストレーション自動応答 (SOAR) のサービスです。AI を利用した脅威の検出・アラートの削減などログを一元管理し、分析、検知、自動対応

>>Azure Sentinel 資料はこちら

4. Microsoft Azureではじめるデータ基盤の導入入門ガイドブック

ここまでデータ基盤導入のポイントステップをご紹介してきました。クラウドAuzreを活用すれば小さいデータから始めることが可能ですし、失敗したとしてもやり直しが簡単です。もしやってみたいデータ分析がある場合には、まずはスモールスタートから初めて収集→加工/可視化→分析のPDCAを回しながら活用の範囲を広めてみてはいかがでしょうか?

なお、今回ご紹介した内容は下記の資料に詳細を記載しております。

具体的な構成案や導入する際の費用など知りたい方は、ぜひこちらの資料も参考に見てみてくださいね。

\Azure活用でデータ基盤を導入したいIT担当者の方向け/

この記事を書いた人

- Azure導入支援デスク 編集部

-

こんにちは!日商エレクトロニクスでは、Microsoft Azure活用に関する有益な情報を皆様にお届けしていきます。Azure移行、データ活用、セキュリティなどに関するお困りごとや、Microsoft Azureに関する疑問点などお気軽にご相談ください。

ブログにしてほしいネタなどのリクエストもお待ちしております。

この投稿者の最新の記事

- 2024年3月27日ブログデータレイクとは? ~DWHとの違い、メリット、活用例などをわかりやすく解説~

- 2024年3月6日ブログデータカタログとは?~機能、導入のメリット、導入方法まで解説~

- 2024年2月19日ブログMicrosoft Azure とは?基本概要、5大メリット、主要サービスを解説

- 2024年2月6日ブログ今さら聞けない「DWH」とは? ~データベースやデータマートとの比較も含めて解説!~